AI-Beobachtbarkeit für Infrastruktur, Workloads und Pipelines in einer Plattform

Vereinheitlichen Sie alle Signale in Ihrer KI-Umgebung, damit Sie von der reaktiven Brandbekämpfung zur strategischen, datengesteuerten Entscheidungsfindung übergehen.

Vereinheitlichen Sie alle Signale in Ihrer KI-Umgebung, damit Sie von der reaktiven Brandbekämpfung zur strategischen, datengesteuerten Entscheidungsfindung übergehen.

Hören Sie auf, Daten durch verschiedene Tools zu jagen. Dank der umfassenden Transparenz Ihrer KI- und IT-Umgebungen kann Ihr Team schneller agieren, Fehler intelligenter beheben und sich auf das Wesentliche konzentrieren.

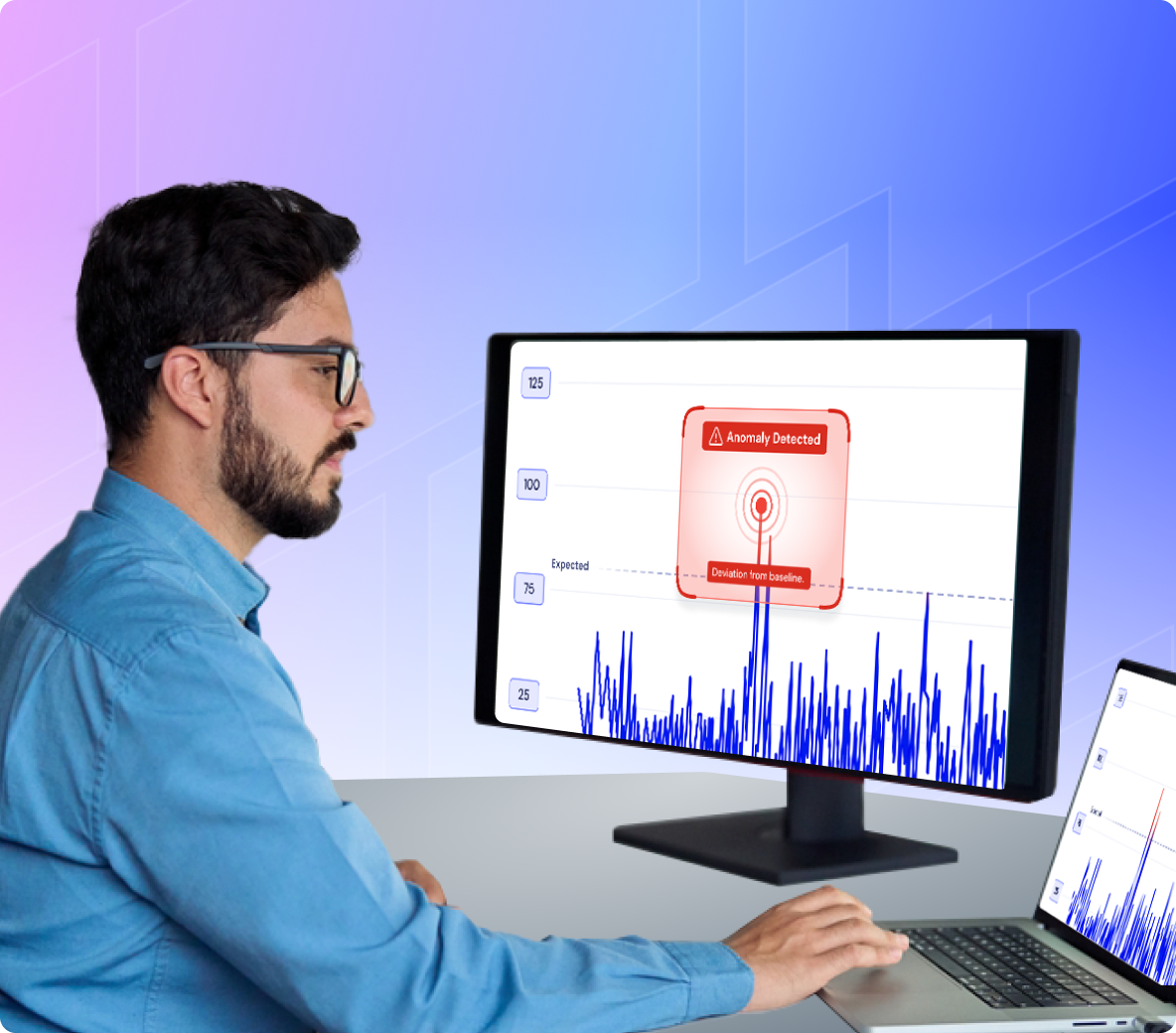

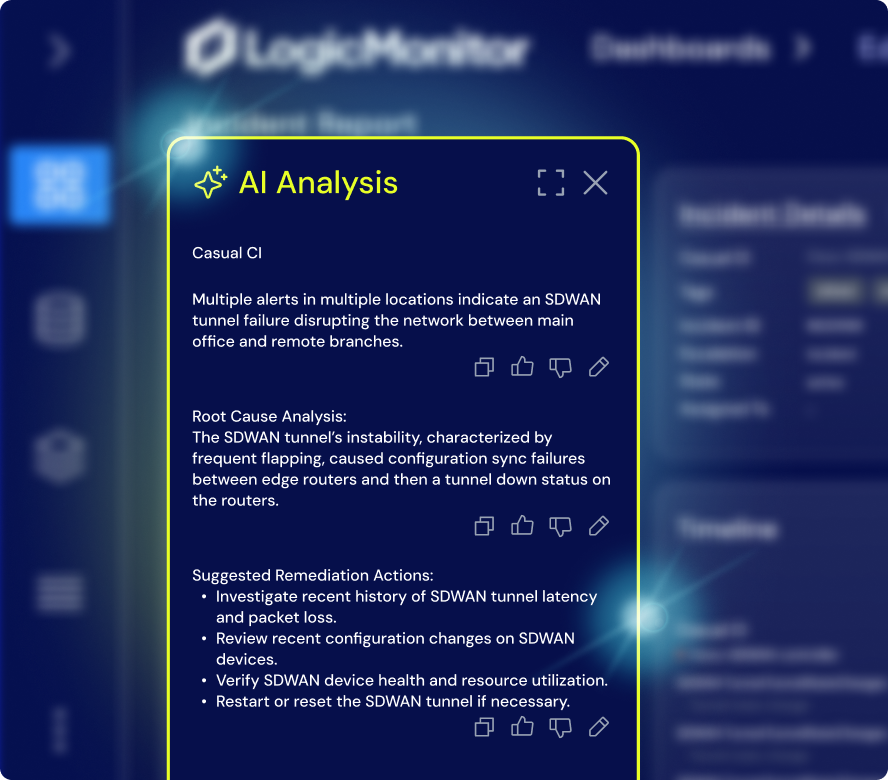

Erkennen Sie Anomalien proaktiv, bevor sie die Dienste unterbrechen. Durch die frühzeitige Erkennung und den Einblick in die Grundursache reduzieren Sie Ausfallzeiten und vermeiden Rätselraten.

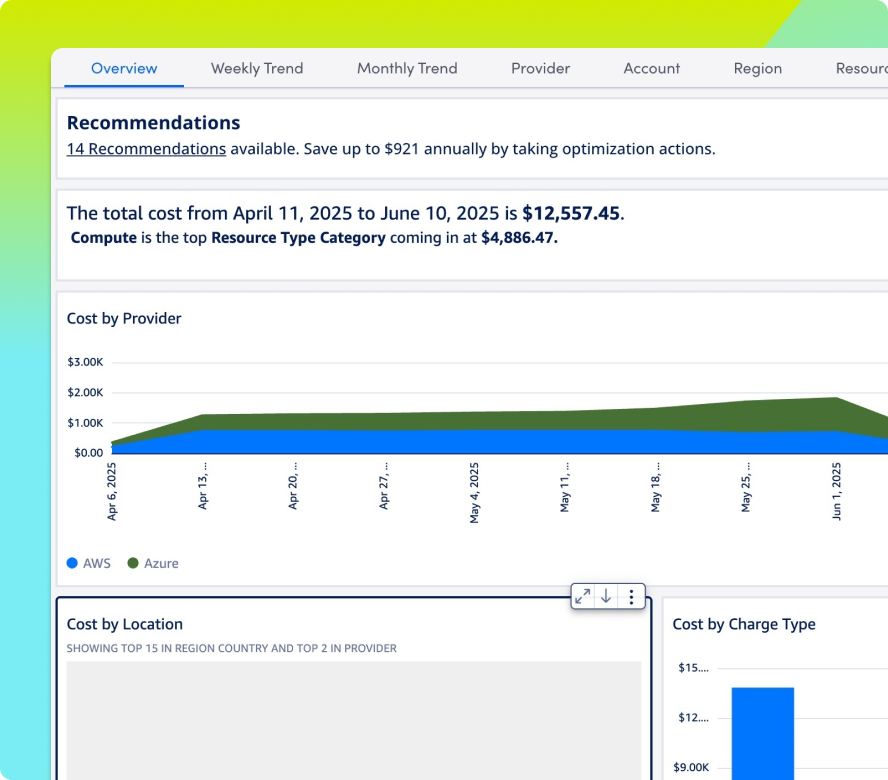

Vermeiden Sie Budgetüberraschungen mit integrierter Transparenz über ungenutzte Ressourcen, nicht ausgelastete GPUs und ausufernde Rechenleistung, bevor sie sich auf die Ausgaben auswirken.

LogicMonitor hält mit der Entwicklung Ihres Stacks Schritt. Neue Systeme werden automatisch entdeckt, ohne manuellen Aufwand und ohne Lücken in der Abdeckung.

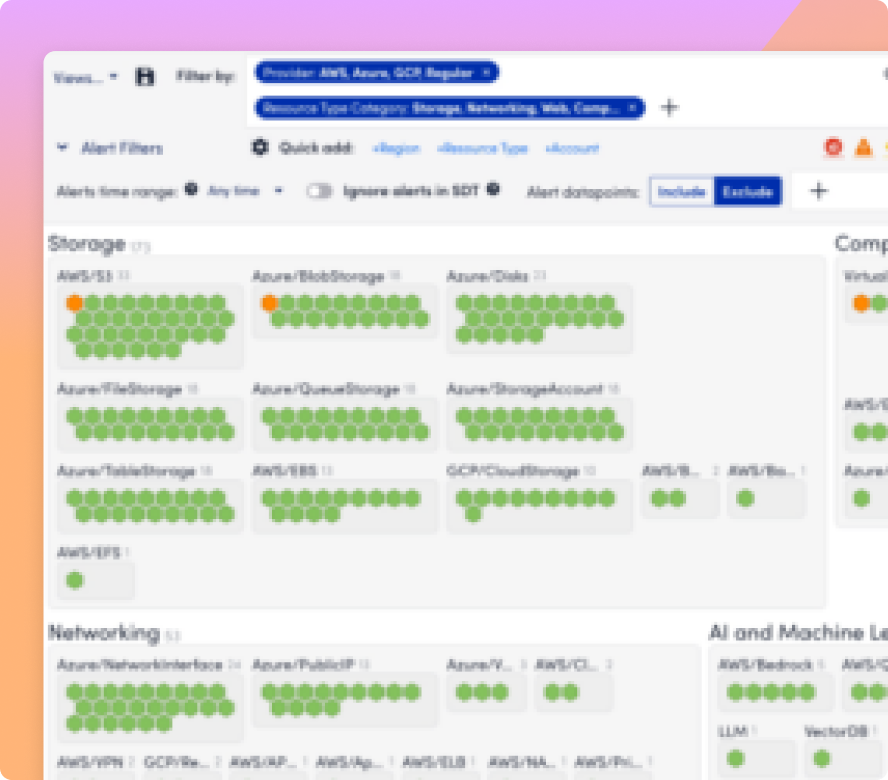

Überwachen Sie den Zugriff, die Nutzung und das Systemverhalten in Ihrem gesamten KI-Umfeld. Erkennen Sie unregelmäßige Aktivitäten, bevor sie zu einem Verstoß oder einer Serviceunterbrechung führen.

Verwandeln Sie komplexe Kennzahlen wie KI-Kosten, Betriebszeit und Systemleistung in übersichtliche, umsetzbare Dashboards, die die Ausrichtung, Investitionen und intelligentere Entscheidungen fördern.

OBSERVABILITY – UNTERSTÜTZT DURCH LOGICMONITOR ENVISION UND EDWIN AI

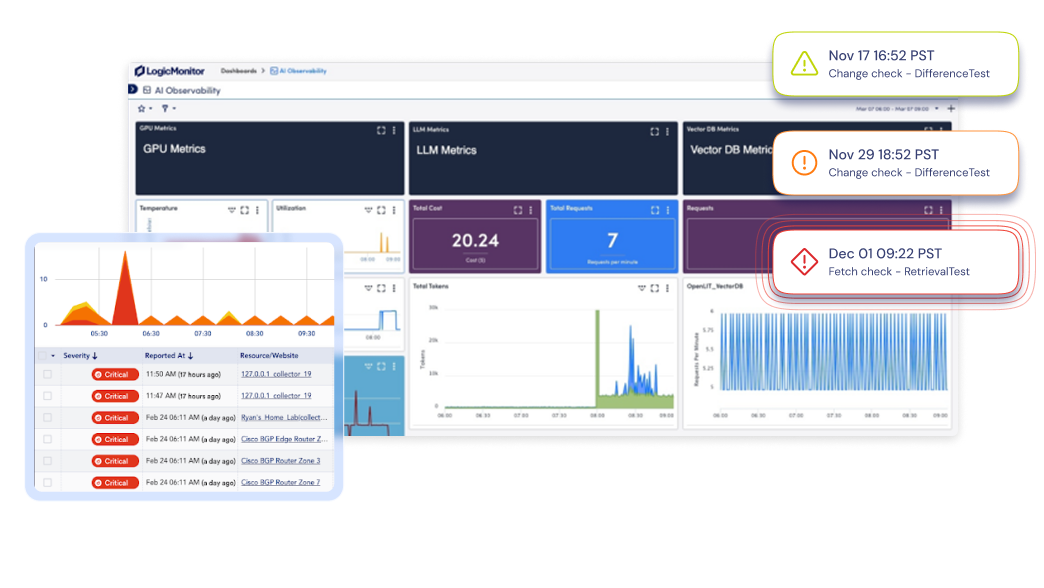

Mit Echtzeit-Transparenz, automatischer Erkennung und KI-Korrelation unterstützt LM Envision Sie bei der Überwachung jeder Ebene Ihrer KI-Infrastruktur, damit Sie Ausfallzeiten verhindern, Ausgaben verwalten und schnell handeln können.

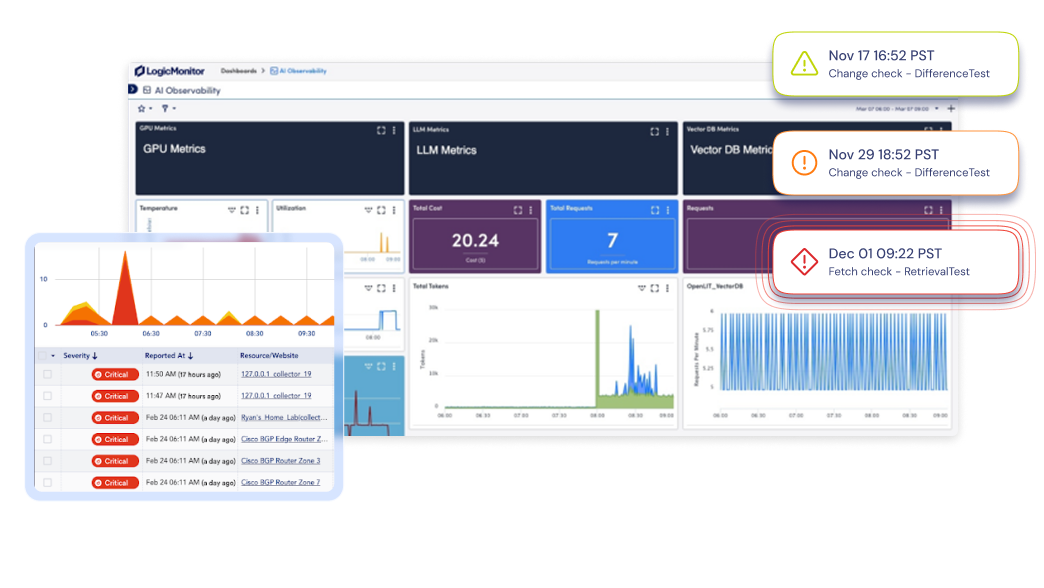

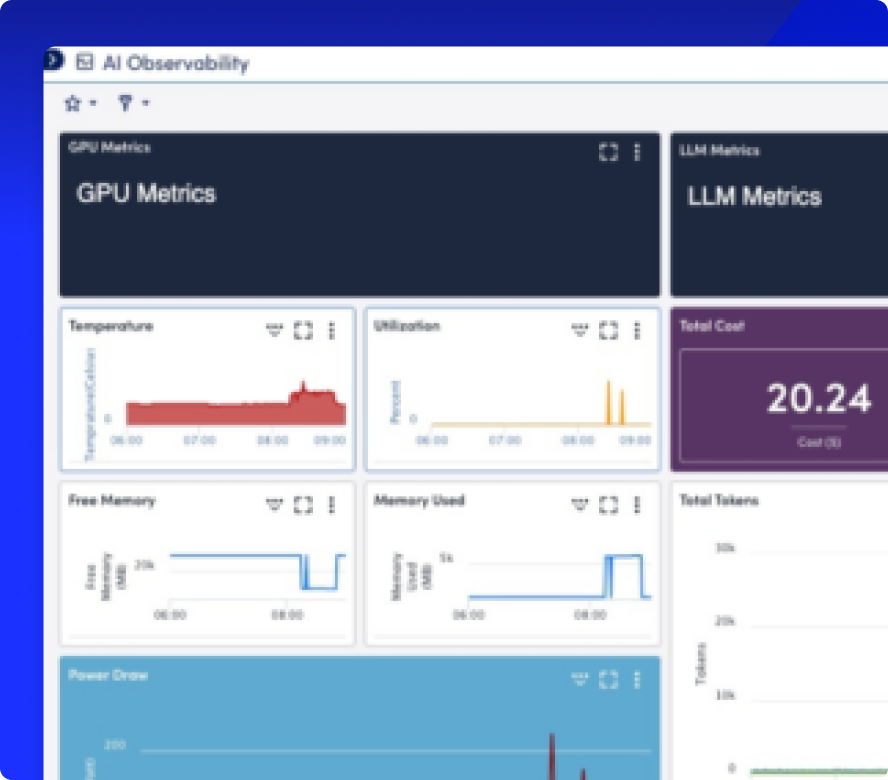

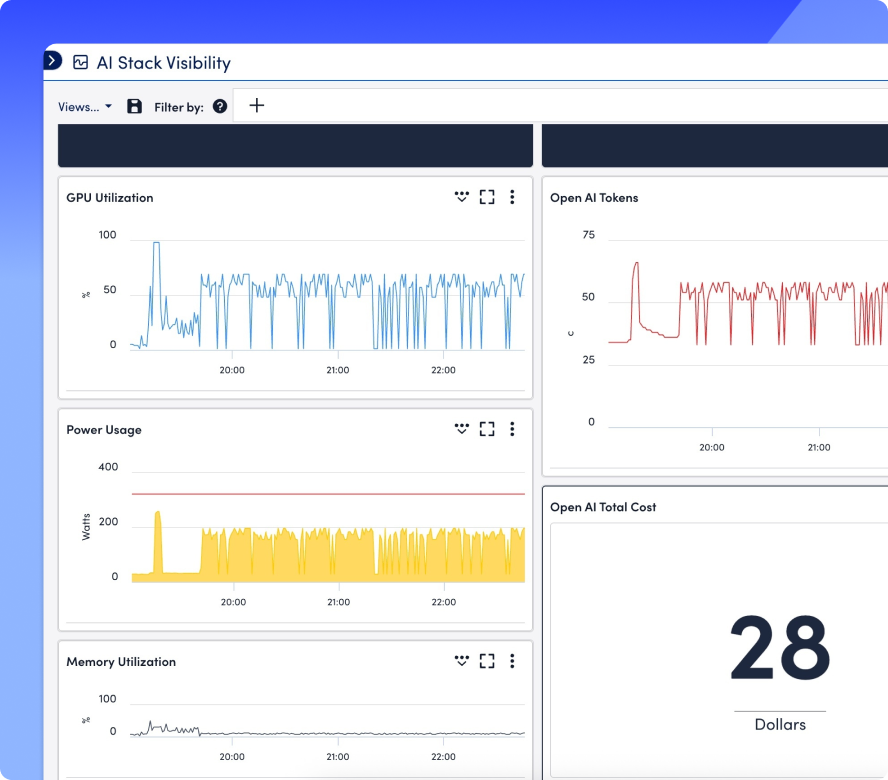

Bringen Sie GPU-Metriken, LLM-Leistung und Vektordatenbank-Statistiken in eine einzige Ansicht, damit Sie blinde Flecken beseitigen und jede Schicht Ihres KI-Stacks überwachen können.

Zeigen Sie GPU-, LLM-, Vektor-DB- und Infrastrukturmetriken nebeneinander an, indem Sie vorgefertigte Dashboards verwenden oder eigene Dashboards mit Drag-and-Drop-Anpassung erstellen.

Erkennen Sie ungewöhnliches Verhalten frühzeitig mit der Anomalieerkennung, legen Sie metrikbasierte Schwellenwerte fest und unterdrücken Sie Warnungen mit niedriger Priorität, damit sich die Teams auf Vorfälle mit hohem Sicherheitsrisiko konzentrieren können.Verfolgen Sie jede KI-Anfrage von der API bis zur GPU

Zeichnen Sie Inferenzpipelines auf, verfolgen Sie Servicebeziehungen und visualisieren Sie die Cloud- und On-Premise-Topologie, damit Sie Latenzzeiten schneller erkennen und Fehler schneller beheben können.

Schlüsseln Sie die Token-Nutzung und die GPU-Kosten auf, erkennen Sie ungenutzte Ressourcen und legen Sie mithilfe integrierter Prognosetools, die speziell für KI-Workloads entwickelt wurden, Budgetwarnungen fest.

Erfassen Sie KI-spezifische und Infrastrukturprotokolle, um Anomalien zu erkennen, Zugriffsmuster zu verfolgen und revisionssichere Protokolle für die Einhaltung von Standards wie HIPAA und SOC 2 zu exportieren.

Integrationen

LM Envision lässt sich mit über 3.000 Technologien integrieren, von Infrastruktur- und ITSM-Tools bis hin zu KI-Plattformen und Modell-Frameworks. Erfassen Sie Metriken von GPUs, LLMs, Vektordatenbanken und Cloud-KI-Diensten und synchronisieren Sie angereicherten Vorfallskontext automatisch mit Tools wie ServiceNow, Jira und Zendesk.

100%

Collector-basiert und API-freundlich

3,000+

Integrationen, stetig wachsend

KI-Agent für ITOps

Edwin AI nutzt agentenbasierte AIOps, um ITOps zu rationalisieren, indem es Rauschen reduziert, die Triage automatisiert und selbst in den komplexesten Umgebungen für eine Lösung sorgt. Kein manuelles Nähen. Kein Schwenken des Stuhls.

67%

weniger ITSM-Incidents

88%

weniger Alarmflut

Zahlen & Fakten

Antworten erhalten

Erhalten Sie die Antworten auf die wichtigsten Fragen zur KI-Überwachung.

KI-Beobachtung ist die Fähigkeit zu überwachen und zu verstehen, wie sich KI-Systeme in der Produktion verhalten. Sie hilft Teams dabei, Modelldrift zu erkennen, Latenzzeiten festzustellen und stille Fehler aufzuspüren, indem Erkenntnisse aus Infrastruktur, Modellen und Anwendungen in einer Ansicht zusammengefasst werden.

Bei der herkömmlichen Überwachung werden CPU, Speicher und Betriebszeit überwacht. Die KI-Beobachtung verbindet diese Signale mit dem Verhalten des Modells, z. B. mit Output-Änderungen, Leistungsverlangsamungen und ungewöhnlichem Verhalten der Agenten.

Idealerweise vor der Produktion. Es ist viel einfacher, Ihre KI-Systeme vom ersten Tag an zu verfolgen, als später Sichtbarkeitslücken zu schließen.

Ja. LogicMonitor sucht nach ungewöhnlichen Mustern im System- und Modellverhalten, wie z. B. langsame Antworten, unerwartete Ausgabespitzen oder Verschiebungen in der Nutzung, die oft auf tiefere KI-Probleme hinweisen.

Nein. LogicMonitor verwendet ein Collector-basiertes Modell mit integrierten Integrationen. Sie können mit der Überwachung Ihres AI-Stacks schnell und ohne komplexe Einrichtung beginnen.

Machen Sie sich Ihre AI-Leistung zu eigen

mit LM Envision